こんにちは!みうです!

Metaから新しいOSSのLLM、Llama3が公開されました!

こちらについて、公開されている情報を解説します!

公式のページ

meta社の解説

Introducing Meta Llama 3: The most capable openly available LLM to date

Today, we’re introducing Meta Llama 3, the next generation of our state-of-the-art open source large language model. In the coming months, we expect to share ne...

Huggingface

meta-llama/Meta-Llama-3-8B · Hugging Face

We’re on a journey to advance and democratize artificial intelligence through open source and open science.

Llama2からの違いは?

結論から言うと、LLMあまり大きな違いはないようです。

私の感覚だとマイナーチェンジ。GPT4-1106から、GPT4-0125にアップデート、位の印象を受けました⚾️

では、具体的な変更点を見てみましょう

①学習データの増強、高品質化

ここがいちばん大きな変更点のようです!

- 事前学習において、Llama2の時の7倍、コードは4倍多く含まれる

- 英語以外の言語も積極的に構成(ただ、英語ほどの性能は出ない)

- 高品質なSFT(チャット形式の学習データ)

- PPOとDPO(強化学習による出力傾向の調整)

学習データ自体は公開されておらず、地味な変化ではあるのですが、精度には抜群に貢献する変化です🍎

②モデルアーキテクチャの変更

モデルアーキテクチャは、以下の2点が変更点のようです。

- Grouped Query Attention(GQA)の(継続)採用

- Tokenizerに新規トークンを追加

GQAはLlama2でも採用されていた効率的にattention計算する機構です。

Tokenizerと併せてどちらも、性能をあげると言うより、コスパ良く推論することを重視しているようです

公式サイトには、モデルアーキテクチャとありますが、結局はそこまで大きな変更ではないようです

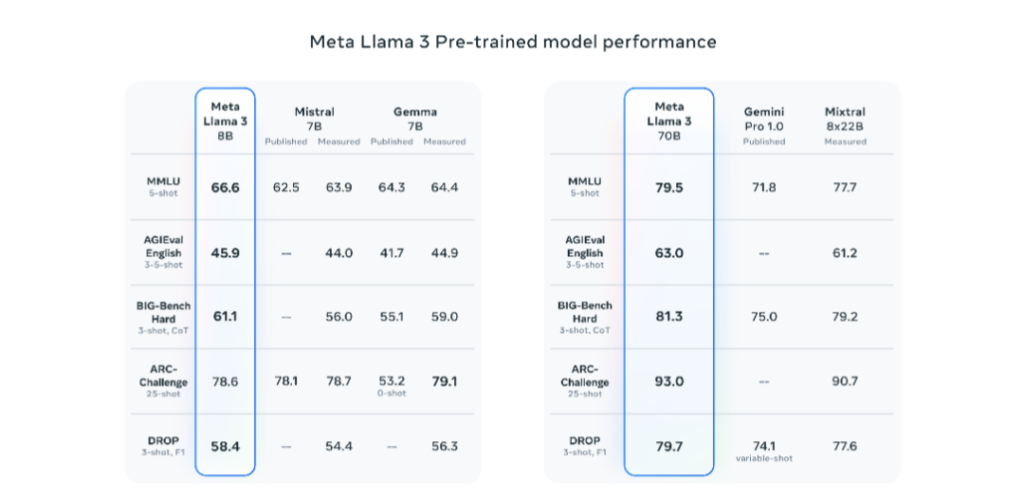

英語性能

高いらしいです!

ただ私の知識だとこのベンチマークがどうなのかは分かりません。また、GPT4とも比較しておらず、おそらく比較の上で負けているため、意図的に公開していない比較なのかなと思います。

日本語性能は?

これは、想定通り、このままだと微妙そうです。

Hugging chatの画面

日本語で質問しても英語で返答してしまいます。これはSFTのデータが英語に偏っていることが原因です。

日本企業による日本語追加学習が楽しみですね♪

Meta社の今後の予定

以下の内容は現在作成中だそうです。

- 長文化

- 新機能(画像の読み込みなど?)

- 別のパラメータのモデル(MoE形式など?)

は今後発表予定との事です!