こんにちは!みうです!

今日はお金の話です。ビジネスをする上では非常に重要な内容ですね。

LLMのランニングコストはとても費用がかかる

LLMの動作にはGPUが必要です。このGPU、言うまでもないですが高いんですよね

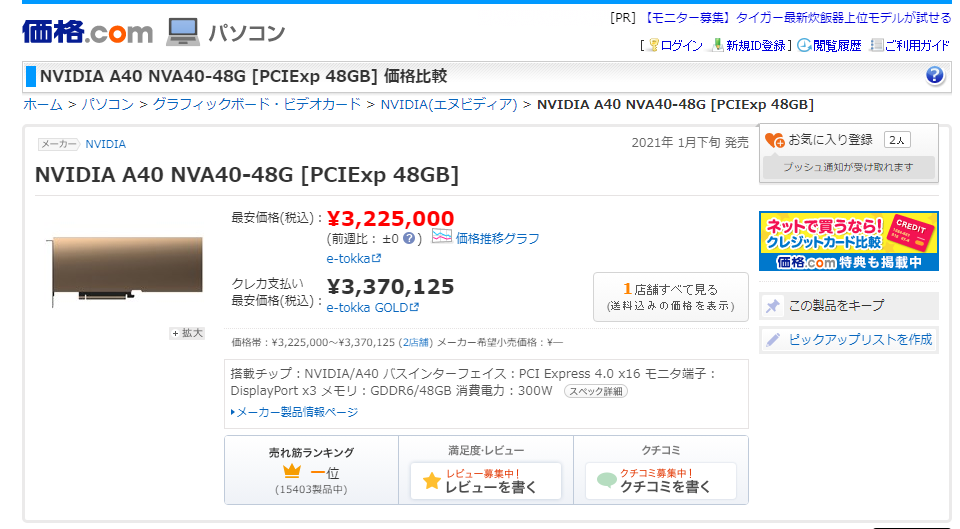

例えば、1枚で、13B相当のLLMがギリギリ推論できるA40(48GB)は、本日の地点で330万程度で販売しています。

2枚で、7x8Bや70BのLLMがギリギリ推論できるA100(80GB)はもはやありません。

ただ、前述のとおり、A100はA40よりGPUメモリが大きく、基本的にはA40よりは高くなります。そしてこれが2枚あって、やっと8x7Bや70Bが推論できます。700万円~1000万円くらいは必要そうですね

最新のH100は約500万円で売っています。

また、最新のB200は1000万円程度(B100で500万円程度)で販売しています。

高くないですか?

これらのGPUはそもそもかなりでかいため、当然そこらのPCには刺さらず、ちゃんとしたサーバーが必要です。サーバー代、電気代、メンテナンスの費用、トータルだとかなりかかります。

結論① GPUが高額すぎて、LLMを動かすのは金がかかる

ほんと頭が痛いです

AzureOpenAIはどういう仕組みなのか

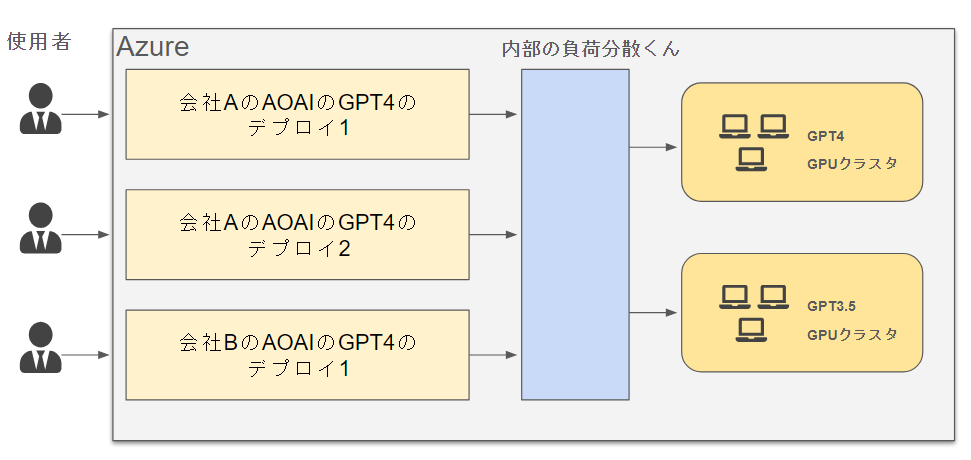

SAASですから、以下のような仕組みであることが推察されます。

デプロイという名前になっているため、個社で1個のGPUマシンが使っているように見えますが、歳費的に現実的ではありません。また、別途、「GPUマシンごと借りる形態」の契約があることから、基本的にはAzureのデプロイする形式は、広い範囲でGPUを共有している形態ということで間違いはないでしょう

AzureにはPTUという形式があります。プロビジョニング スループットの略で、GPUを占有的に使える形の契約ですね。費用感は以下でつぶやいている方がいらっしゃいました。

15万6000ドルというのは、2500万円/月です。うわぁって感じしますよね

おそらくこれは、Azure側でしっかり利益が出る構造の費用となっています。

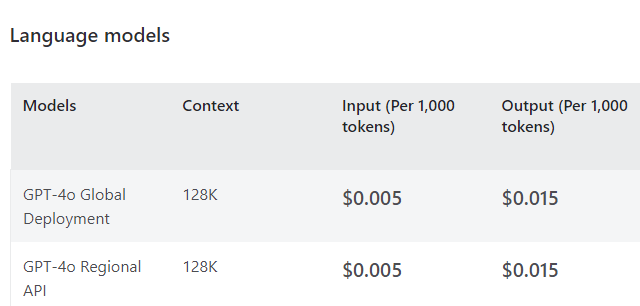

一方、Azure OpenAIのトークン当たりの料金は「OpenAI社のAPI費用」を追随しています。

ポイントは、AzureOpenAIの費用は、OpenAIの費用に追随しているという点です。

AzureOpenAIは必ずしもクラウドベンダとして「利益のでる費用設定」を出来ているとは限らず、赤字覚悟のかなり厳しい値段設定をしている可能性があります。

例えば、Azureが利益を出すための試算をしてみます。

Azureの提供しているA100のGPUのインスタンスの料金は

| Standard_NC48ads_A100_v4 |

およそ月140万円程度です(為替に依存して変動)。月140万円は売価ですから、当然利益も含まれています。

このA100x2枚のインスタンスでは、8x7Bや70Bなどの重たい分だけ精度に優れたLLMを推論することが可能です。おそらくGPT4も速度を見るにこの程度と推測しています。

必要なGPUは、

元のパラメータ量 x 対応可能なトークン長 / 量子化

あたりで見積もれます。長文対応なモデルはデプロイでそもそもコストがかかります

では、AOAIがこの140万円のインスタンスからSaaSでサービスするとします。少しだけブレイクダウンしてみます。

140万円/月=35万円/週=5万円/日=2100円/時

最低でも1時間に2100円程度必ず稼ぐくらいが最低ラインとなります。

GPT4(8k)の費用は、

入力(1kトークンあたり):0.03ドル=4.5円

出力(1kトークンあたり):0.06ドル=9円

です。RAGのように入力トークンが多いユースケースもあれば、「旅行プランを考えて」のような出力が多いユースケースもあります。試算上は今回は、平均で、

6.75円/1kトークン

とさせてください。

この時、2100円を稼ぐために必要なトークン量が計算できます

2100円/時 = 311kトークン/時 = 280k文字/時 = 28万文字/時

28万文字、なかなかに多いです。

ここで、もう別軸から計算してみましょう。LLMは多少並列に推論を行うことができますが、パラメータが多いほど推論は遅いです。

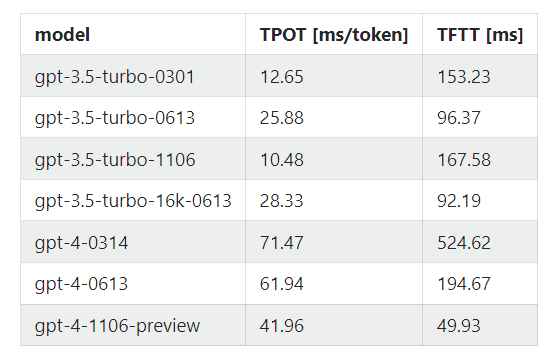

例えばこちらの記事では、GPT4の推論時間は以下のように測定されています

GPT4では、1トークンの生成に60ms程度かかります。

逆に言うと1並列の条件下において

1時間=60分=3600秒において、3600 / 0.06 = 60k(トークン)

生成することができます。

ここまでの状況を整理します

- A100x2枚程度必要なLLMを稼働させて元を取るには、311kトークン/時が必要

- GPT4の推論速度では、1hに60kトークンしか生成できない

- このため、最低でも、5人が並列の状態で昼も夜も同時にパンパンにリクエストを送り続けないといけない

ちなみにLLMは同時接続数を増やすと、生成時の遅延が大きくなる傾向にあります。それを改善するにはインフラを強くする必要があり、コストが上がります

結論② AzureOpenAIはかなり安く売りだしていると思われる

結局のところ、GPUやインフラを含めた投資の回収は、AOAI単体では出来ていないと思われます。一方、AOAIを使うことで、プライベートエンドポイントやストレージなどほかのサービスを使う可能性も高く、そこなど周辺サービスの使用率上昇は多少考えられます。

そして、GCPやAWsなど他社ベンダーも、Azureの費用をターゲットに価格決めをしていると思われ、低価格でのサービス提供を強いられていると思っています。

NvidiaのGPUについて

NvidiaのGPUを買っているのはどこか、というのをまとめていた記事がありました。

Meta、Microsoft、Google、Amazonの4社でH100の売り上げの40%を占めるそうです。

学習でも推論でも使うとはいえ、相当買っていますね

GPUの故障は

適切な使用をしていればそこそこ持ちます。

冷房がOFFにされているとGPUは90度くらいまで上昇して壊れることはあります。適切に空調が効いていれば問題はありません。

H100は保証期間が3年間となっています。

単純な話、毎年1万基のGPUを買っていれば3年後には3万基のGPUを積んだサーバーの運用が必要になります。

とはいえ、アメリカの超大手がこれだけの量を買ってくれるという超高需要な環境下では、Nvidiaは高付加価値によって稼ぐべきです。

そのため以下のような記事が見受けられます

めちゃめちゃ稼いでますね💦

結論③ MicrosoftやAWS、Google、MetaはNvidiaのGPUが高くても買いまくっている

ここまでの情報の整理と関連付け

ここまでの情報を整理すると以下のようなお金の流れになりそうなイメージを持っています

以下のイメージです

[GPU開発ベンチャー]Nvidia

現状もっとも利益を得ている。スピード感をもってAIブームの覇者になるべく動くクラウドベンダーすべてに高額なGPUを卸し続けており、高い利益率で稼ぎ続けている。

[LLM開発ベンチャー]OpenAIなど

基本的にベンチャー企業であり、投資を得るのが最も重要なミッション。単体で稼ぐよりも企業価値を高めるのが重要であり、LLM開発ベンチャーにおいては、LLMを多くの人使ってもらい、知名度、商品としてのLLMの有効度を広めるのが重要。低価格で広くLLMを使ってもらい価値を上げたい。

[ユーザー企業]日本企業含め多くの企業

安価なLLMのサービスで技術検証を進め、業務効率化や価値創出をしたい。OpenAIやAOAIの価格を前提としてサービス化や商品化を進めている。適正価格となった際にふりを被る可能性もありうる

[クラウドベンダー]Azure, AWS, GCPなど

LLMを使った生成AIのサービスとその周辺基盤獲得のために、先行投資を進めて覇権を争う

この図の形にすると、クラウドベンダーの戦略・金によってこの大きな流れは全てクラウドベンダーから出ているんだなぁとしみじみ感じます。

一方、クラウドベンダーから出ている投資が渋ったシナリオというのも考えられます。

その場合、

- Nvidiaは今までのように高額でGPUを販売し続けることができなくなる

- OpenAIはもっと高額に、適切に元が取れるサービス価格で提供せざるを得なくなる

- ユーザー企業は、せっかく開発したサービスがOpenAIやAOAIの値上げで台無しになってしまう

こういった可能性があり得ます。結局のところ、きっかけが上場会社であるGoogleやMicrosoft、Amazonの投資状況1択で、3社が影響を受ける構図になっています。その分この3社が相当タフな投資をしていることが推察されますね。

私はPaypayのように、赤字覚悟でもシェアを取るべき分野としてクラウドベンダーがかなり頑張っている印象を受けています

まとめ

再掲しますが、本日の内容は感想です。投資を推奨するわけでもないですし、こうなるとも限りません。ただ、明らかに価格とコストが一致していないような、そういった気配を感じています。AOAIのあの値段が、いつまでも続くと考えるのがちょっと危険かなと思ってみました!

何かの参考になれば幸いです!ありがとうございました!